Die Methoden der Künstlichen Intelligenz (KI) und dabei insbesondere des Maschinellen Lernens (ML) finden mehr und mehr auch ihren Einsatz in der Robotik. Dabei stützen sich besonders viele Ansätze auf die Übertragbarkeit von in der Simulation gelernten Abläufen auf die Realität (Sim2Real Transfer). Im Projekt MeSSeR wird untersucht wie die Mensch-unterstützte Synthese von Simulationsumgebungen zum erfolgreichen Transfer von gelernten Handlungen in die echte Welt beiträgt und wie dieser Ansatz durch den Einsatz erweiterter und virtueller Realitäten (AR/VR) als Ergebnis eine direkten Interaktion eines Menschen mit einer Simulationsumgebung umgesetzt werden kann. Diese Art der Interaktion sichert eine intuitive Interaktion und erleichtert die räumliche Wahrnehmung der simulierten Umgebung und deren Variabilitätsmodell durch den Menschen. Genauer soll in MeSSeR eine Werkzeugkette entworfen, implementiert und evaluiert werden, die das Erstellen einer Simulationsumgebung anhand eines Scans der Umgebung durch den Roboter, das semantische Annotieren bzw. spezifisches visuelles Markup der Simulation durch einen Menschen in AR/VR, die visuelle Verifikation der eingegebenen Variabilität, sowie das Generieren von Daten aus der aus dieser Variabilität zufällig parametrisierten Simulationen zum Maschinellen Lernen von Roboteraktionen in der Umgebung ermöglicht.

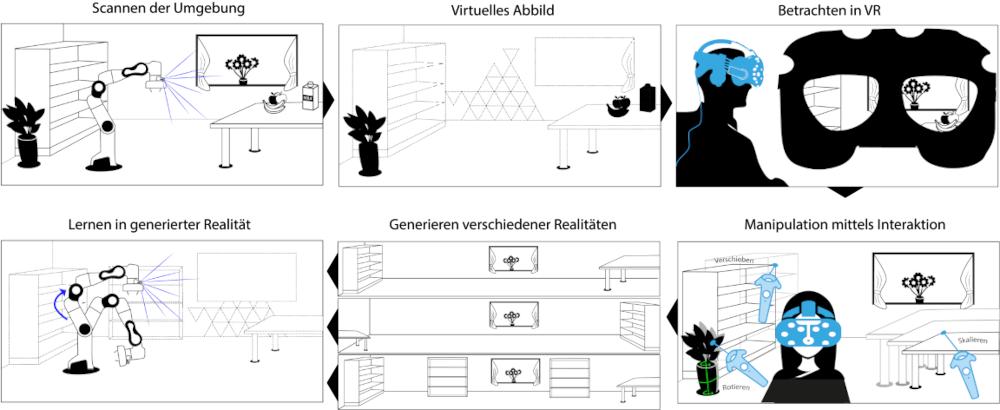

Abbildung 1 stellt den Prozess der Mensch-unterstützten Synthese von Simulationsumgebungen dar. Zuerst werden roboter-zentrische 3D-Tiefenbilder der Umgebung durch eine Kamera am Roboter aufgenommen. Die resultierenden Daten werden registriert, zu einer konsistenten Karte zusammengeführt und zu einem zusammenhängenden texturierten Mesh konvertiert. Weitere Verarbeitungsschritte bereiten das 3D Modell der Umgebung weiter auf die Weiterverwendung in der Simulation sowie zur Interaktion vor, z.B. Flächenerkennung, semantische und Instanzsegmentierung. Das aufbereitete Mesh dient dann als Umgebung für die AR/VR-Interaktion durch einen Menschen. Um die Interaktion des AR/VR-Nutzers mit der Umgebung zu erleichtern kann zuvor eine semantische und Instanzsegmentierung erfolgen. Der AR/VR-Nutzer soll aber auch die Möglichkeit haben Bereiche für die manuelle Vorverarbeitung auszuwählen, z.B. für eine händische semantische Segmentierung. Dies geschieht durch Controller-Eingaben. Zur weiteren Verarbeitung kann nun mit Hilfe von ML Methoden eine Objektrekonstruktion stattfinden, um die zu einem Objekt gehörenden segmentierten Bereichen in 3D Objekte zu verwandeln. Daraus resultierende Löcher in dem unterliegenden Mesh, z.B. des Tisches auf dem ein Objekt segmentiert wurde, können mit Inpainting Methoden aufgefüllt werden.

Als Experte für die Anwendung, für die der Roboter trainiert werden soll, kann der Mensch nun Parameter und Zusammengehörigkeiten für die Simulation generieren. Der AR/VR-Nutzer kann nun segmentierte Objekte als Pinsel verwenden und die Bereiche in der Umgebung markieren, an denen sich diese Objekte aufhalten können. Dabei wird zusätzlich zu den reinen Orten auch eine Verteilung der Aufenthaltswahrscheinlichkeit des Objektes definiert. Eine mögliche Eingabe dieser ist die Verwendung einer Farbauftragsmetapher, der AR/VR-Nutzer nutzt das Objekt als Pinselspitze und kann durch mehrfache Bewegung über eine Stelle die "Farbe" dicker auftragen und somit eine größere Aufenthaltswahrscheinlichkeit eingeben. Dies funktioniert auch in dynamischen Referenzsystemen, z.B. die Eingabe der Relation zwischen Kiste und ihrem Inhalt. Des Weiteren können Körpereigenschaften der Objekte definiert werden, z.B. fest oder verformbar. Aus der resultierenden anwendungsbezogenen Simulationsmenge werden dann automatisch multiple Varianten der Simulationsumgebung erstellt, welche die wichtigsten Kombinationen der eingegebenen Variabilität abdecken. Die resultierenden anwendungsspezifisch variierten Simulationsumgebungen können nun zum Training einer KI-Anwendung verwendet werden. Hier kommen Methoden wie Reinforcement Learning zum Einsatz.

Die schnelle automatische Generierung einer Simulationsumgebung aus roboter-zentrischen Sensordaten der Umgebung erfolgt beispielsweise aus der Zusammenführung von 3D Punktwolken. Die Sensordaten werden registriert, zu einer konsistenten Karte zusammengeführt (Fusion) und in ein zusammenhängendes texturiertes Mesh konvertiert. Durch Flächenerkennung und grobe semantische Segmentierung wird das 3D Modell weiter automatisch auf die Verwendung in der Simulation und zur Interaktion vorbereitet.

Die interaktive Eingabe von anwendungsbezogener Variabilität in der Simulationsumgebung in der virtuellen/erweiterten Realität erfolgt durch die direkte Interaktion des Menschen mit der virtuellen Umgebung. Dabei hat der Mensch direkten Einfluss auf die Segmentierung der Umgebung und kann durch Auswahl neuer Bereiche und Anpassung der bisherigen Segmentierung eine Optimierung der semantischen Umgebungssegmetierung durchführen. Der Mensch bringt dabei sein anwendungsspezifisches Fachwissen ein, um die Verteilung der Aufenthaltswahrscheinlichkeit segmentierter Objekte durch Interaktion mit der Simulationsumgebung zu beschreiben. Dieses Zusammenwirken von Algorithmus und menschlicher 3D-Eingabe ist Teil der Innovation von MeSSeR.

Die Generierung multipler Simulationen aus einer aufbereiteten Simulationsumgebung erfolgt aus der annotierten Umgebung, welche eine anwendungsbezogene Simulationsmenge der spezifischen Variabilität darstellt. Es werden automatisch multiple Varianten der Simulationsumgebung generiert, welche die wichtigsten Kombinationen der eingegebenen Variabilität abdecken. Die Bestimmung der wichtigsten Kombinationen der eingegebenen Variabilität ist ein weiterer Teil der Innovation von MeSSeR. Die resultierenden anwendungsspezifischen Simulationsumgebungen können nun zum Training einer KI-Anwendung verwendet werden.

OFFIS - Institut für Informatik

OFFIS - Institut für Informatik

Die Forschungsgruppe Smart Human Robot Collaboration (HRC) am OFFIS - Institut für Informatik in Oldenburg, hat einen starken Fokus auf simultane Lokalisierung und Kartierung (SLAM), Umgebungswahrnehmung sowie Mensch-Roboter-Interaktion. OFFIS wurde 1995 als angewandtes Forschungsinstitut der Universität Oldenburg gegründet und beschäftigt rund 300 Mitarbeiter bei einem Umsatz von knapp 19 Mio. € im Jahr 2019. Die HRC-Gruppe ist Teil des neu gegründeten Forschungsbereichs zur Produktion, der sich mit drei weiteren Bereichen zu den Themen Gesundheit, Energie und Verkehr zusammenschließt. HRC hat vorhandene Expertise aus den Bereichen Mensch-Computer-Interaktion, autonome Systeme und Umweltwahrnehmung gebündelt. Mehrere laufende Projekte untersuchen Sensorfusion, menschliche Bewegungs- und Verhaltensmodelle (OmniConnect), Telemanipulation sowie Remote Telepresence (PIZ), Augmented Reality/Virtuality-Schnittstellen (STEP-UP) und Metriken für die industrielle kollaborative Montage (METRICS).

Universität Duisburg-Essen

Universität Duisburg-Essen

Der von Prof. Dr. Stefan Schneegaß geleitete Lehrstuhl für Mensch-Computer-Interaktion ist am paluno - The Ruhr Institute for Software Technology angesiedelt und befasst sich mit der Erforschung von intelligenten Benutzungsschnittstellen. In seiner Forschung werden Daten von mobilen, tragbaren und ubiquitären Systemen erfasst und durch KI-gestützte Methoden für die Nutzerinnen und Nutzer aufbereitet. Hierbei erforscht er unter anderem den Einsatz von interaktiven Technologien in intelligenten Umgebungen (IoTAssist Projekt) sowie verschiedene Ansätze zur Interaktion in virtuellen und erweiterten Realitäten (ComIC Projekt).

Dieses Forschungs- und Entwicklungsprojekt wird mit Mitteln des Bundesministeriums für Bildung und Forschung (BMBF) im Programm „Erzeugung von synthetischen Daten für Künstliche Intelligenz“ (Förderkennzeichen 01IS21068A) gefördert. Die Verantwortung für den Inhalt dieser Veröffentlichung liegt bei den Autor:innen.

Projektkoordinator

Dr. Tim C. Stratmann

OFFIS e.V.

Escherweg 2

26121 Oldenburg

E-Mail:

tim.stratmann(at)offis.de

Telefon: +49 441 9722-431

Internet:

www.offis.de